明らかな不得意分野も…ChatGPTに医師の代わりはまだムリ

AI診断の危険性についての議論が広がっています。生成AIの活躍する分野が拡大している一方で、医療分野におけるChatGPTの診断能力に疑問が投げかけられています。

PLOS ONEによる研究では、ChatGPTが医師の代わりになるか検証され、不正確な診断結果が多かったことが示されました。

一方、他の分野では生成AIの能力が高く評価されており、使い方次第で様々な分野での活用が期待されています。

AI診断は危険!

いまやChatGPTに頼りっぱなしという人も出てきています。文章を書いてもらったり、プログラミングを助けてもらったり、生成AIの大活躍している分野が拡大中。しかしながら、まだほとんど役に立たないというケースもあるみたいですよ。

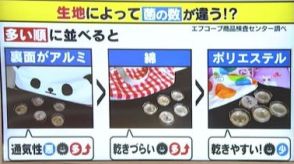

このほどPLOS ONEでは、ChatGPTに医師の代わりが務まるか、150に及ぶケーススタディでテストした研究結果が発表されました。患者の病歴、臨床検査のデータ、レントゲン写真などを見せて、実際に医師の診断能力をテストする課題をChatGPTに出してみます。果たして総合的に診断して、正しい治療方法を示すことができるでしょうか?

これは単なる当てずっぽうでなく、どうしてその診断結果が出され、なぜその治療法が提案されるかまで、詳細に答えの根拠も評価するテストです。

150のテストケースすべてで評価が成された結果、ChatGPTが正確な診断結果と治療法を導き出せたのは、なんと49%に過ぎませんでした。患者の病状について正しく説明できたという評価に限ってもやはり全体の52%と、ほぼ半分のケースではとんでもない診断しか行なえなかったという結果に終わっていますね。

実は今回の発表に先立ち、ChatGPTに米国の医師資格試験(USMLE)を受けさせた例もありました。

こちらは見事にパスしています。それなら実際の診断を医師のようにさせてみれば? やや期待も高まっていたようですけど、まだそこまでのレベルには達していませんでした。重大な症状を見逃して、適切な治療法を提案できなかったり、誤った診断を出してしまったりすると、患者の命にも危険が及びます。ChatGPTには大役すぎましたか?

今回のテストに用いられたのはChatGPT 3.5でした。もっと最新のバージョンだと、もしかすれば、もう少し使いものになったり?

ただ似たような指摘として、実はプログラミング分野でもかなりミスをしていたり、あと以前から医療分野では生成AIなんて頼れないなんて評価まで。とはいえ、患者の気持ちに寄り添ってメールを書くという分野では、明らかに人間の医師よりも上手だという評価が得られたりしています。なにごとも使い方次第なのかもよ~。

Source: PLOS ONE