OpenAI、待望の強化された「Voice Mode」のアルファ版を提供開始

OpenAIの最新のChatGPT Plusでは、待望のVoice Modeがアルファ版として提供され始めた。この新機能により、ユーザーは音声アシスタントとの会話をより自然に行うことができる。

Voice Modeでは、スマートフォンの画面に表示される内容に基づいたアドバイスや、カメラで撮影した内容に即した応答など、マルチモーダルな機能もあるが、アルファ版ではこれらの機能は未対応となっている。

OpenAIは音声機能の安全性向上のため、多言語のレッドチームを活用し、様々なコンテンツやリクエストに対するブロック機能を強化しており、ユーザーからのフィードバックを受けてモデルの改良を行っている。

OpenAIが「Spring Update」というイベントを5月に開催したとき、大きな注目を集めたものの1つが、「GPT-4o」の新しい動画機能と音声機能で大幅に強化された「ChatGPT」の「Voice Mode」のデモだった。そして、この待望の新しいVoice Modeが(不完全ではあるが)ようやく登場した。

OpenAIは米国時間7月30日、強化されたVoice Modeを「ChatGPT Plus」の一部ユーザーにアルファ版として順次提供していくことを「X」(旧Twitter)への投稿で明らかにした。この高度な音声アシスタントにより、ユーザーはアシスタントの会話に割り込んだり、自分の感情に即した応答を得たりできるようになる。

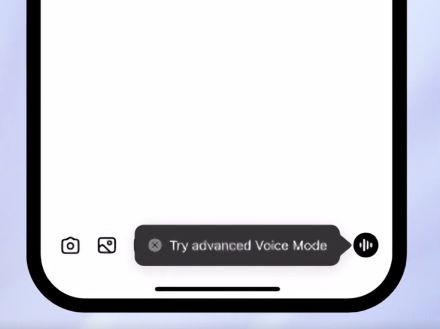

アルファ版へのアクセスが許可されたユーザーには、手順が記載されたメールが送られるほか、上の動画にあるように、モバイルアプリにメッセージが表示される。また、通知が一切届いていなくても心配はいらない。OpenAIによれば、同社は今後もユーザーを順次追加し、秋にはすべてのChatGPT Plusユーザーがアルファ版にアクセスできるようにする計画だという。

下の動画にあるように、OpenAIはSpring Updateイベントで行った初めてのデモで、Voice Modeのマルチモーダル機能を披露した。このマルチモーダル機能には、ユーザーのスマートフォンの画面に表示されている内容に基づいてアドバイスをしたり、ユーザーがスマートフォンのカメラで撮影している内容に即した応答をしたりするといった機能もある。

だが、Voice Modeのアルファ版にはこれらの機能がない。OpenAIによれば、「動画と画面の共有機能は後日リリースされる」という。また、初めてのデモ以降、音声会話の品質と安全性の向上を図ってきたと同社は述べている。

Xのスレッドによれば、OpenAIは音声機能のテストにあたって、45の言語にまたがる100人以上で構成された外部のレッドチームを活用したという。また、あらかじめ設定された4種類の音声のみで会話するようにモデルをトレーニングし、それ以外の音声での応答をブロックしたほか、暴力的なコンテンツや著作権で保護されたコンテンツを求めるリクエストをブロックするガードレールを実装した。

さらに同社は、ユーザーからのフィードバックに基づいてモデルの改良を重ね、制限や安全性評価など、GPT-4oのパフォーマンスに関する詳細なレポートを8月に公開する予定だとしている。

ChatGPT Plusに加入するには、月額20ドル(約3000円)が必要だ。加入すれば、高度なデータ分析機能や画像生成機能を使ったり、GPT-4oへの優先アクセス権を得たりできるといったメリットもある。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。