「DirectML」がSnapdragon X Elite/Copilot+ PC対応 ~ハードウェア支援AI処理が身近に

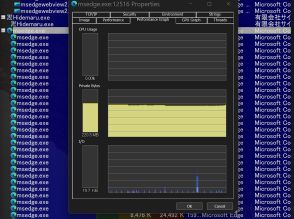

MicrosoftはSnapdragon X Eliteを搭載したCopilot+ PCにDirectMLとWebNNの対応を発表。

DirectMLは様々なハードウェアで高性能プログラミングが可能になるAPIで、Copilot+ PCで活用できる。

WebNNはWebブラウザーで機械学習モデルを実行可能にし、NPUを利用できる開発者プレビューが公開された。

米Microsoftは8月29日(米国時間)、「DirectML」が「Snapdragon X Elite」を搭載した「Copilot+ PC」に対応したと発表した。「WebNN」への対応も着実に進んでいるようだ。

■ DirectML

「DirectML」は「DirectX」ファミリーの一部で、どのベンダー(Intel、AMD、Qualcomm)のどのようなハードウェア(GPU/NPU)でも、アプリ開発者が一貫した手法で、ハイパフォーマンス、高効率なプログラミングが行えるように整備されたAPI群。これから本格展開される「Windows Copilot Runtime」の基盤コンポーネントでもある。

Qualcomm製の「Snapdragon X Elite」は強力で高効率なNPU(AI処理に特化したプロセッサー)を搭載しているが、それを活用するにはこれまでプラットフォーム固有の対応が必要だった。「DirectML」が対応すれば開発や移植の負担が軽減され、少しの労力でハードウェアの性能を最大限に引き出せる。

「Copilot+ PC」で「DirectML」プログラミングを始めるには、以下が必要だ。

・「DirectML」最小バージョンv1.15.2(ARM64)

・「ONNX Runtime」最小バージョンv1.18(ARM64)

・「Windows 11 バージョン 24H2」およびそれ以降

・「Qualcomm Hexagon NPU Driver」最小バージョンv30.0.31.250およびそれ以降

まだ開発プレビューの段階で、いくつかの制限事項がある点には注意したい。

■ WebNN

一方の「WebNN」は、Webブラウザーで機械学習(ML)モデルを実行する仕様だ。Windowsの場合、「DirectML」を介したGPU/NPUアクセラレーションにより、AIをローカルで実行できるようにする。また、「ONNX Runtime」プロジェクトの一部である「ONNX Runtime Web」(ORT Web)のような機械学習フレームワークとの統合もサポートしている。

今回発表された「WebNN」最新版の開発者プレビューでは、WindowsデバイスでNPUを利用できるようになった。Intel AI Boost搭載のIntel Core Ultraプロセッサーと、Qualcomm Hexagon NPU搭載のCopilot+ PCがサポートされている。

「DirectML」対応デバイスで「WebNN」を開始するには、次のものが必要となる。

・「Windows 11 バージョン 24H2」以降

・プレビュー版の「Microsoft Edge」(Canary/Dev)

・「WebNN」NPUパートナーからの最新ドライバー

・Intel Core Ultra NPU Driver for Windows

・Qualcomm Hexagon NPU Driver Package for Windows

「Edge」の試験機能フラグ(about:flags)で「WebNN」を有効化して「DirectML」再配布可能パッケージをインストールしたのち、指定された機能フラグを付けて「Edge」を起動すると、「Edge」で「WebNN」が利用できるようになる。まだ開発初期のためかモデルの起動時間は1分以上かかる場合もあるが、これはいずれ改善されていくだろう。