Oracle、富士通と協業しミッションクリティカル業務をクラウドに移行したい日本企業をAlloyで支援

Oracleが米国ネバダ州で開催したイベントで、OCIの基調講演や富士通、Uberの事例が紹介された。

OCIが新しいAIスーパーコンピュータを導入する計画を発表し、Blackwellを活用した高性能を目指す。

富士通はOCIのAlloyを活用し、日本企業向けのクラウドサービスを提供すると発表した。

データベース、クラウド・サービス・プロバイダー(CSP)のOracleは、9月9日~9月12日(現地時間)に米国ネバダ州ラスベガス市の会場で、同社の年次イベント「Oracle CloudWorld 2024」を開催している。会期3日目(9月11日)の午前中には、Oracle OCI担当 上席副社長 クレイ・メイゴーク氏によるOCI(Oracle Cloud Infrastructure)に関する基調講演が行われた。

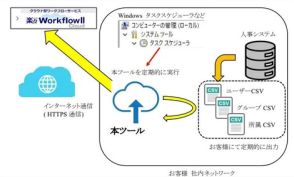

この中で富士通が、OCIの提供するAlloy(OracleのパートナーとなるCSPが自社の顧客に提供するクラウド基盤)を活用して、日本独自のニーズを満たしたクラウドサービスの活用を行う事例を紹介した。

またOracleは、NVIDIAのBlackwellをベースに最大13万1072基を1クラスタとして扱うことを可能にし、最大で2.4ZFLOPSのピーク性能を実現するOCI向けのAIスーパーコンピュータを、2025年に導入すると明らかにした。

■ アニメスタジオSkydance Animation、OCIを活用してクラウドへアニメ作成基盤を移管

Oracle OCI担当 上席副社長 クレイ・メイゴーク氏は「昔は少ないコンテナを利用して物流を構築していたが、今では考えられないような数のコンテナを運んでいる。港、空港、鉄道、そしてラストワンマイルとして道路などを整備して円滑に運べるようにしなければならない。今のITも同じで、すでに1930年代のような巨大コンピュータは使っておらず、クラウド、それもたくさんの種類のクラウドを活用して構築されており、顧客が自分に適したクラウドの技術を選択できるようにすることが重要だ。特にクラウドは伸縮が可能な仕組みになっており、大きく使うこともできるし、小さく使うこともできる。我々OCIは、そうしたクラウドの変化をリードしていきたいと考えている」と述べ、さまざまなクラウドベースのサービスを提供していくことで、エンタープライズと呼ばれる大企業から、社員数がそこまでは多くないような中小企業まで、さまざまなレベルの企業が抱える課題を解決していきたいと強調した。

メイゴーク氏はそうした最初の事例として、OCIのパブリッククラウドを利用しているアニメスタジオになるSkydance Animation 技術担当上級副社長 グレゴリー・ブレンティン氏をステージに呼び、Skydance AnimationがどのようにOCIのパブリッククラウドを利用しているのかを説明した。

ブレンティン氏は、「現在我々は、3拠点にあるアニメスタジオが協力しあってアニメを作成している。それぞれ異なるタイムゾーンにある、異なる場所の3拠点が協力するのには、OCIの提供するクラウドサービスの利便性が高い。特にアニメ制作では、ピーク時にはそれこそ普段の十倍の性能やリソースが必要になる。OCIであればそうしたリソースの伸縮を自由自在に行えるので、大きな効果がある」と述べ、アニメスタジオでクリエイターが効率よく作業を行うためには、OCIのパブリッククラウドが大いに役立っていると説明した。

ブレンティン氏は「来年にはスタジオ全体のリソースをOCIに統一したいと考えている。それにより、3つの拠点をよりよく効率よく運営できるようになる。さらに効率よくアニメを作成できる体制を整えたい」と述べ、現在はオンプレミスになっているリソースなども含めてOCIに移行したいと表明した。

■ Dedicated Region25が発表され、3ラックから6ラック、最終的には千を超えるラックまでスケーラブルに対応可能に

次いで、Oracleのメイゴーク氏は、OCIが顧客企業に提供している「専用リージョン」(Dedicated Region)、そして同社のパートナー企業がその顧客に対してOCIのインフラを利用してクラウドサービスを提供できる「Oracle Alloy(アロイ)」に関する説明を行った。

今回のOracle CloudWorld 2024において、Oracleは「専用リージョン」の最新版として「専用リージョン 25(Dedicated Region25)」を発表している。簡単に言うと、専用リージョンというのは、顧客企業のオンプレミスデータセンターの中に、OCIのフルサービスを提供できるソフトウェアスタックを含んでいるOCIの機器を置き、顧客企業のサーバーと高速なネットワークで接続することで、顧客企業のデータセンター上で動いているサーバーとOCIのサービスとが高度に融合して動く、といったサービスになる。

今回発表された専用リージョン25では、1つのラックは4600CPUコア、76TBのメモリ、2.4PBのストレージ、6.4Tbpsのネットワーク帯域幅というスペックになっており、3つのラックが最小構成である。

さらに、その倍の6ラック、64ラックなどにスケールアウトすることも可能で、最大では数千ラックという構成も可能だとメイゴーク氏は説明した。専用リージョン25は、2025年に一般提供開始が予定される予定だ。

■ 富士通は日本企業のニーズを満たしたクラウドサービスを提供するため、OCIのOracle Alloyを選択したと説明

もう1つのAlloyは、OCIのインフラを利用し、パートナー企業がCSPとしてサービスを提供する仕組み。例えば、日本では富士通がそのパートナーになって、OCIのインフラを利用してクラウドサービスを構築し、日本の顧客向けに、同社がサーバー管理やデータのプライバシー管理などに責任を持ってサービスを提供する形になる。

その富士通からは、執行役員SEVP システムプラットフォームビジネスグループ長 古賀一司氏がゲストとして登壇し、富士通がどのようにAlloyを利用しているのかを説明した。

古賀氏は「日本の顧客にとっては、ミッションクリティカルなシステムで、このタイミングでパッチが当たると困るような時でも、管理権が与えてもらえなかったり、またデータの管理権の観点からも日本法律でデータを日本国内に置く必要があると法律で定められている業界があって、そのままではパブリッククラウドへ移行するのは難しいという議論になっていたりした。そういうことを制御できるクラウドはないのかと検討してきた結果、OCIのAlloyがベストだということになり、採用を決めた」と述べ、OCIが提供するOracle Alloyを富士通が採用し、同社の日本の顧客に対して富士通がすべてを管理して提供するという形にすることで、日本のミッションクリティカルなデータを扱う企業などが、オンプレミスからクラウドへの移行を実現していくことが可能になったと説明した。

例えばパッチの適用に関しては、一般的なパブリッククラウドサービスでは、CSP側の都合でパッチが当てられることになり、顧客がサービスを中断してほしくない時に中断されてしまうという課題がある。その意味では、顧客企業側でそれを管理(例えば、土曜の朝はダメだが、日曜の夜ならよい、など)できればいいのだが、その管理権を顧客に渡していないパブリッククラウドサービスが一般的で、それも日本企業がクラウドへ移行できない理由の1つになっていた。

そこで、富士通が2025年度から提供する予定の「Fujitsu Uvance」のハイブリッドクラウドサービス版では、そうした管理やデータの管轄を富士通が行い、日本企業のニーズを満たしてクラウドへの移行を促すという取り組みを、富士通とOCIが協力して行っているのだ。

基調講演後に行われた質疑応答の中で、富士通の古賀氏は、2025年度からのサービスインに向けて、現在OCI側とさまざまな取り組みを行っている段階で、「OCI側と議論していく中で、日本企業が必要とするソブリン(統治)要件が106件あることが明らかになったが、OCI側と話し合う中で、その106件の要件すべてを満たしてもらった」と説明。日本企業がオンプレミスからクラウドへ移行するにあたり、必要と考えていたデータの管轄権、パッチ適用のタイミングの管理権など、さまざまな要件をOCI側と協力して富士通が管理運営できることが確認されたため、OCIのOracle Alloyを選んだのだと語っている。

■ UberはそのIT基盤をクラウドへ移行するにあたりOCIを選択した理由がマルチクラウドだと説明

9月10日(現地時間)のラリー・エリソン会長 兼 CTO(最高技術責任者)の基調講演の中でも強調された、同社のマルチクラウド戦略(Oracle Databaseを、Oracle自身のOCIだけでなく、競合のAWS、Google Cloud、Microsoft Azureで動作させること)についても再度説明があり、Google Cloud 副社長 兼 プラットフォーム事業部長 アミット・ザベリー氏が登壇。前日のエリソン会長の講演で紹介されたAWSとの取り組みに続いて、Oracle DatabaseのGoogle Cloudでの取り扱いについて説明が行われた。

Oracleによれば、今回のCSP3社との提携は、OCIのOracle Database向けの設備そのものがCSP3社のデータセンターに入る形になる。その上で、CSP3社のマネージドサービスが動くことになり、Google Cloudで言えばGoogle Cloudの管理コンソールからOracle Databaseを管理し、Googleが提供するGeminiなどのAIサービスから、顧客がOracle Database上に格納するデータを使って、カスタムのAIアプリケーションを構築することなどが可能になる。

現状としては、Google Cloudに関してはすでに4つのリージョンで提供開始しており、日本など、まだサービスインが開始されていないリージョンに拡大されていく見通しだ。なお、AWSは既報の通り2024年の末にプレビュー提供が開始され、2025年にサービスイン、Microsoft Azureに関してはすでに6つのリージョンで一般提供が開始されており、日本でも2024年中に提供開始予定となっている。

また今回の基調講演では、Uberがそのサービスの運営基盤としてOCIを選び、その作業が完了したことが明らかにされた。Uber 技術戦略・クラウドエンジニアリング担当 上級部長 カムラン・ザルガヒ氏は「Uberでは、1時間あたり100万回を超える旅行注文が発生している。これをいかに安定して従来のシステムからクラウドに移行させるかが大きな課題だった。OCIは我々の成長を実現するためのマルチクラウド環境が用意されていることなどが選択の理由になった」と述べ、UberがOCIを選んだ理由はマルチクラウドの環境が充実しているからだと説明した。

Oracleの発表によれば、UberはAMDプロセッサベースのOCI Computeでアプリケーションからのリクエスト処理を行い、同じくOCIが提供するAmpere ArmプロセッサベースのOCI Computeでワークロード処理などを行っているという。また将来的には、「OCI AI infrastructure」を利用したAI機能も実装される見通しで、OCIが提供するHadoopのファイルシステムやOCI Object Storageなどにデータが置かれて、学習などにデータが活用される計画だ。

■ OCIが2.4ZFLOPSの性能を実現するNVIDIA Blackwell GPUベースのAIスーパーコンピュータを発表

Oracleのメイゴーク氏は最後に、「ゼタスケール(性能がZFLOPSに達する)」なAIスーパーコンピュータをOCIで提供していく計画を明らかにした。メイゴーク氏によれば、このゼタスケールなAIスーパーコンピュータは、NVIDIAが3月のGTCで発表した次世代GPU「Blackwell」がベースになっており、最大で13万1072基のBlackwellを1つのクラスタとして構成できる。

クラスタはGB200(BlackwellのうちGPUが2つ、NVIDIAのArm CPUであるGraceが1つ搭載されているモジュール)が最大72基、1つのラックに搭載されている「NVIDIA GB200 NVL72」がベースで、水冷技術を利用して冷却される。

GPUはラック内部および外部で、ConnectX-7 NIC、ConnectX-8 SuperNIC、あるいはNVIDIA Quantum-2 InfiniBandなどのイーサネットないしはInfiniBandの高速なネットワークを活用してスケールアウトされる仕組みになっており、最大で13万1072基までスケールアウトされる。

現状のOCIに用意されているH100ベースのAIスーパーコンピュータは、最大1万6384基までスケールアウトされて65EFLOPS(エクサフロップス)の性能を実現し、ネットワークは13ペタビット/秒のスループットが実現されている。H200ベースのAIスーパーコンピュータでは、最大6万5536基までスケールアウト可能で、260EFLOPSの性能と52ペタビットのネットワークスループットが実現されている。

それに対して新しいBlackwellベースのAIスーパーコンピュータでは、13万1072基とGPUの数がH200ベースと比較して2倍になり、ネットワークのスループットも129.6ペタビット/秒となり、ピーク性能は2.4ZFLOPSと10倍近くに達する。

Oracleは、このゼタスケールのAIスーパーコンピュータの導入時期に関しては明らかにされていないが、Oracleのプレスリリースの中では、NVIDIAのBlackwellは2025年の前半に提供開始される見通しと説明している。そのため、それ以降に提供が開始されることになる可能性が高い。

なお、NVIDIA側のリリースではBlackwellのリリース時期に関しては触れられていない。NVIDIAは3月のGTCで、Blackwellの出荷時期は年内とだけ説明しており、(出荷が延期されるという報道はあったものの)NVIDIAは最近の決算発表で予定通り年内に出荷開始すると確認しており、現時点ではBlackwellのリリース時期が2025年前半になったという正式な発表はされていないことは付記しておく。