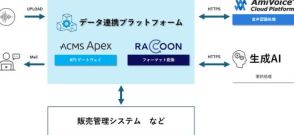

ピクセルカンパニーズ、生成AI向けに特化したコンテナ型データセンターソリューションを販売

ピクセルカンパニーズ株式会社はGPUに特化したコンテナ型データセンターソリューションの販売を開始し、2024年に稼働開始予定のデータセンターを通じて企業や大学・研究機関向けに展開する。

コンテナ型データセンターは工期が短いため、早期のGPUサーバー利用・サービス提供が可能であり、さらに環境負荷を抑えたグリーンコンピューティングを実現するために水冷式冷却装置を採用している。

今後は日本全国にデータセンターを展開し、生成AIの利用環境を整備することでイノベーションを促進し、競争力を向上させることを目指している。

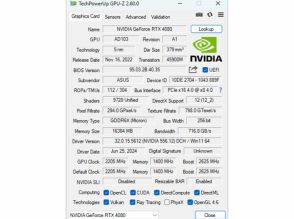

ピクセルカンパニーズ株式会社は22日、生成AI利用への需要拡大に対応するため、GPUに特化したコンテナ型データセンターソリューションの販売を開始した。データセンター事業でパートナーシップを組む、スーパーマイクロ株式会社、エヌビディア合同会社との協業を通じ、企業や大学・研究機関など幅広いユーザー向けに展開する。販売当初の仕様では、GPU「NVIDIA H100」を搭載する計画。

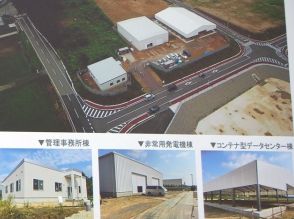

ピクセルカンパニーズでは、経済産業省の補助金を受け、福島県大熊町にコンテナ型データセンターの建設を進めており、2024年中の稼働開始を予定している。このデータセンターの建設を通じて培ったノウハウをパッケージ化して、コンテナ型データセンターソリューションとして販売する。

ピクセルカンパニーズのコンテナ型データセンターソリューションは、AI向けサーバー製造で豊富な知見を持つスーパーマイクロから技術提供を受けて設計しており、GPUラック、冷却装置、発電装置をコンテナの規格に合わせて個別に製作し、現地で組み上げる工法を採用している。このため、柔軟な設備運用と更新が可能で、GPUの開発サイクルが加速度的に進む中でも、常に新しい製品を導入しやすい点に強みがあるとしている。

また、建物型のデータセンターを建設する場合、通常4~5年の工期を要するのに対し、コンテナ型では全対抗機を半年程度に短縮できると説明。最小でコンテナ5台と冷却塔など必要整備を置ける広さがあれば設置可能で、用地確保も容易だとしている。

環境負荷を抑えたグリーンコンピューティングの観点から、サーバー冷却装置には水冷式を導入している。GPUはCPUと比較して発熱量が高く、一般的な空冷式では冷却効率および電気使用量に課題がある。ピクセルカンパニーズのコンテナ型データセンターソリューションは、冷却水を循環利用することで、空冷式と比べ使用電力を15~20%削減、計算リソースに試用できる電力を38%増加させている。

ピクセルカンパニーズでは今後、日本全国にデータセンターを配置していく構想で、顧客が生成AIを利用しやすい環境を整備することにより、イノベーションを促進し、競争力を向上できるよう支援していくとしている。

■ コンテナ型データセンターにより早期のGPUサーバー利用・サービス提供を可能に

ピクセルカンパニーズ代表取締役社長の吉田弘明氏は、2021年12月に経済産業省から同社が自立・帰還支援雇用創出企業立地補助事業(製造・サービス業等立地支援事業)の実施事業者として採択され、2022年8月に正式に交付が決定したと説明。これを受け、現在、福島県大熊町にGPUに特化したコンテナ型データセンターの構築を進行中で、データセンターは2024年12月に完成予定としている。

吉田氏は、2022年からどのようなデータセンターを作るかを構想していく中で、従来のようなデータセンターでは競争が難しいと考え、GPUに特化したコンテナ型データセンターを構築することにしたと説明。この構築で得られたノウハウをパッケージ化して、ソリューションとして販売していく。

ピクセルカンパニーズのコンテナ型データセンターソリューションは、合計5台の20フィートの水冷式コンテナ(GPU搭載コンテナ4台、管理用コンテナ1台)で構成される。冷却設備は、各コンテナに水冷式ラック4つとin Rowチラー2つを搭載。さらに合計810kWの熱交換能力を持つ冷却塔を3台搭載する。計算処理用と管理用に最大20ラック設置でき、合計で最大512基のNVIDIA H100 GPUの搭載が可能となる。ネットワークは、AI用にInfiniBand NDRまたは400GbEの利用が可能。最大消費電力は1MWまで対応する。

コンテナ型データセンターの利点については、工期が短いこと、水冷式の導入がしやすいこと、用地確保が容易であることを挙げている。特に、大規模なデータセンターでは特別高圧電力の引き込みが難しいという問題があるが、ピクセルカンパニーズのコンテナ型データセンターは高圧電力の範囲で建設でき、必要台数分のコンテナを設置可能な広さがあれば、どこにでも設置が可能だとしている。

また、コンテナからGPUラック、冷却装置など、すべてが設計済みのパッケージのため、

設計から仕様決定までの時間が短く、部材ごとの分割発注や管理などの手間が不要で、ピクセルカンパニーズとスーパーマイクロのスタッフが構築から運用までサポートするため、専門スタッフが不在でも安心して利用できるとしている。

コンテナ型データセンターの活用例としては、企業が自社の研究リソースとして活用するケースを挙げ、クラウドサービスや既存のGPUサーバーをレンタルするのではなく、購入することで高度な計算能力が得られ、リアルタイムデータ処理が可能、自社内でデータを管理することによるセキュリティ、ニーズに応じたカスタマイズ性といったメリットがあるとした。

また、ハイパースケーラー向けデータセンターの建設に比べて、コンテナ型データセンターの構築は容易であり、急成長中のGPU特化型データセンター市場に向け、サーバーレンタル事業をスムーズに開始でき、安定した収益と市場での競争優位を確立できるとした。

ピクセルカンパニーズ自身が大熊町に建設しているコンテナ型データセンターでは、NVIDIA H100を搭載するスーパーマイクロのサーバーを、ベアメタル型でユーザーに提供していく予定。これと同様な仕様のコンテナ型データセンターを、企業の研究機関やサービス事業者向けにソリューションとして販売していくもので、年間3セットほどの販売を計画していると語った。

■ 今後はサーバーの水冷化がトレンドに

スーパーマイクロ ゼネラルマネージャー FAE&ビジネスデベロップメントの佐野晶氏は、スーパーマイクロの売り上げは近年大きく伸びており、この伸長はAIブームのおかげとも言えると説明。今回のピクセルカンパニーズの水冷システムのように、ラックに必要なものを組み込んで納品する、ニーズに応じて最適化したラックソリューションの展開を進めているとした。

サーバーの状況については、CPU、GPUとも消費電力が劇的に増加しており、水冷化が大きなトレンドになっていると説明。水冷ソリューションには、チップなどの発熱箇所を液体で冷却する液冷方式、サーバー本体を冷却液に直接浸す液浸方式、サーバーからの排気をラック背面の水冷装置で冷却するリアドア方式などがあるが、今回のピクセルカンパニーズでは、サーバーの発熱をクーラント液をラック内循環させることで冷却し、熱交換器経由で冷却塔などから外部に廃熱する液冷方式を採用している。

また、スーパーマイクロでは、同社のサーバー用に最適化したコールドプレートや、ホットスワップ可能なポンプを備える熱交換ユニット(CDU)、逆弁内蔵バルブ採用で結露対策済みのホース/チューブなども開発している。今回のピクセルカンパニーズ向けのラックでは、NVIDIA H100を搭載するサーバーを予定しているが、さまざまなサーバーに対応可能で、次世代のNVIDIA B200にも対応できるとした。

スーパーマイクロ Director of Salesの福元健之氏は、ピクセルカンパニーズとはこれまで2年ほど協議してきおり、そのノウハウを他社にも販売しようというのが今回のパッケージだと説明。GPUサーバーの販売は好調だが、現状のGPUサーバーは空冷でもなんとか対応できても、次世代のGPUサーバーは水冷でないと厳しいとした。

一方で、既存のデータセンターやサーバールームでは、水冷サーバーへの対応は困難な場合が多く、そうした顧客にはコンテナ型データセンターを紹介していくこともあると説明。土地さえあれば、既存データセンターの隣にコンテナ型データセンターを設置するといったことも可能で、こうした取り組みにより高性能なGPUサーバーを設置できる場所が増えていくことに期待していると語った。