ピクセルカンパニーズ、生成AI向けコンテナー型データセンターを発表

ピクセルカンパニーズが生成AI向けのコンテナー型データセンターを発表。最大512基のNVIDIA H100 GPUを搭載可能で、福島県に建設する計画。

コンテナー型データセンターは短期間で設置可能で、柔軟な設備運用と更新が可能。水冷方式の採用により電力消費を削減し、高性能GPUに対応。

AI研究開発や投資商材としての利用が見込まれるデータセンターソリューション。水冷対応サーバー製品のラインアップも拡充。

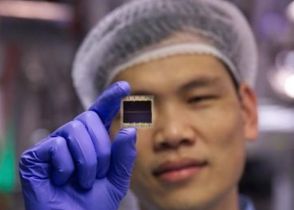

データセンター事業などを手掛けるピクセルカンパニーズは8月22日、生成AI向けのコンテナー型データセンターを発表した。スーパーマイクロおよびエヌビディアとの協業に基づく取り組みで、GPUに「NVIDIA H100」を採用し、最大512基を搭載可能としている。企業や大学・研究などに提供するという。

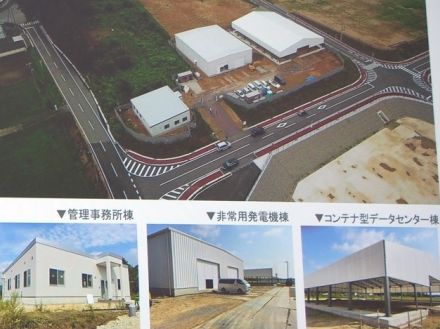

説明を行ったピクセルカンパニーズ 代表取締役の吉田弘明氏によれば、同社では、経済産業省の東日本大震災復興支援事業を通じて、2022年から福島県大熊町にコンテナ型データセンターの建設を進めており、12月に完成を予定する。今回発表したソリューションは、この建設を通じ培ったノウハウをパッケージ化して提供するものといい、今後は全国に配置していく構想だという。

吉田氏は、2年前からコンテナー型データセンターソリューションを検討する中で、先端のGPUサーバーを搭載することを目指したとする。今回のコンテナー型データセンターは、スーパーマイクロから技術提供を受け設計しているとし、GPUラックや冷却装置、発電装置をコンテナーの規格に合わせて個別に製作、現地で組み上げる工法を採用する。吉田氏は、「2年前から取り組んできたことで、短期間かつオールインワンで発注から構築できることが大きなメリット」と強調した。

ハイパースケーラーが利用するような建物型のデータセンターでは建設に通常4~5年程度の工期を要するが、コンテナー型では6~9カ月程度に短縮できるとし、柔軟な設備運用と更新が行え、GPUの開発サイクルが加速度的に進む中でも、新製品を導入しやすい利点があるという。同社のソリューションでは、最小で20フィートサイズのコンテナー5台(GPUサーバー用4台と管理用1台)と冷却塔など必要設備を置ける広さがあれば設置でき、用地の確保を容易とする。

また、喫緊で需要が高まるAI用途などの高性能GPUでは電力消費が大きく、冷却も大きな負担になる。今回のサーバーの冷却には水冷式を採用し、冷却水を循環利用することで空冷式よりも使用電力を15~20%削減できる一方、計算リソースに使用可能な電力を38%増加させているという。各コンテナーで水冷式ラックを4台、In Rowチラーを2台搭載し、さらに合計で810キロワットの熱交換能力を持つ冷却塔を3台搭載する。

同社では、企業や公共系組織などでのAI研究開発あるいは投資商材としての利用を見込んでいるという。

今回サーバーなどのシステムを提供するスーパーマイクロ ゼネラルマネージャー FAE&ビジネスデベロップメントの佐野晶氏は、現在ラック単位でシステムを納入するラックソリューションが中心であると説明し、特に水冷方式の採用が急速に進んでいるとした。

背景にはCPUやGPUなどのプロセッサー製品の高性能化と発熱量の増大があり、ラック単位で10キロワット以上となることから、従来の冷気では難しくなりつつある。同社では、水冷で使用するコールドプレートやCDU、CDM、ホース・チューブなどを外部調達から自社開発に変更し、水冷装置の信頼性向上に取り組んでいるとした。

また、水冷対応サーバー製品のラインアップも拡充しており、今回のソリューションでは、1台当たりHGX H100を8基、1コンテナー当たり最大128基搭載可能とする。ネットワークでは、最大8つのInfiniBand NDRもしくは400GbE イーサネットを接続できる。なお、将来的には「HGX B200」を採用することもできるという。

スーパーマイクロ シニアセールス・ディレクターの福元健之氏は、「ピクセルカンパニーズと2年前から仕様を検討していく中で、気軽にデータセンターを利用できることを目指した、GPUサーバーの販売は、この1~2年で非常に伸びている。しかし、GPUサーバーの電力消費が増え、次世代のHGX B200では空冷がほぼ困難と言われており、既存のデータセンターに水冷設備を導入するのも制約がある中で、コンテナー型を採用されるケースが増えつつある」などと説明した。

ピクセルカンパニーズの吉田氏によれば、今回のソリューションはGPUサーバーの計算資源に特化している。このため、大規模言語モデル(LLM)開発など大規模データを格納するストレージは必要程度で、福島県大熊町で設置する施設も福島県内のデータセンターと専用線で接続する構成になるという。