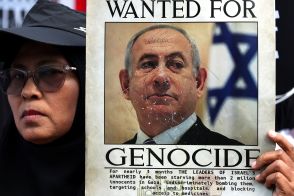

イスラエルは、AIによって多くの無関係の人が「ハマス」として殺害対象になることを知っていたが、問題ないとした

2023年10月から始まったガザ地区への攻撃において、イスラエル軍がAIを使用して殺害対象を特定したが、その精度に問題があり、多くの無関係なパレスチナ人が犠牲となった。

ラベンダーを使用した上級将校の証言者Bによると、AIシステムの評価が独立して精査されず、誤った標的が選定されることがあった。

標的生成マシンがハマスの戦闘員と似た通信パターンを持つ人物を誤って特定し、問題の根源がAIの不正確さにあることが明らかとなった。

2023年10月から始まったガザ地区への攻撃においてイスラエル軍は、殺害対象となる大量の「標的」をAIを使ってマークした。しかし、AIの精度は確実でなく、エラーがある。それを認識していながらも対策しなかったことによって、ハマスとは無関係の多くのパレスチナ人が殺害されることになった。(この記事は第2回/全5回)

ラベンダーを使用した上級将校である証言者Bは、取材に対し、現在の戦争で諜報機関の職員たちはAIシステムの評価を独立して精査することを求められていないと繰り返した。それは時間を節約し、支障なく人間の標的を量産できるようにするためだ。

「すべてが統計的に、とてもドライに整然とおこなわれた」とBは言う。この監視の欠落は、内部調査でラベンダーの正確性が90%にとどまるとわかっていたのに承認されたという。言い換えるなら、殺害対象とされた人間の標的の10%はハマスの軍事部門のメンバーではまったくないと、事前に知られていたのだ。

たとえば、ラベンダーはハマスやPIJの戦闘員と似ている通信パターンを持つ人物を誤って戦闘員とみなすことがよくあったという。そこには、警察、民間防衛組織のメンバー、戦闘員の親戚、名前やニックネームが戦闘員とたまたま似ているだけの人、かつてハマスの戦闘員が使用していた携帯電話の端末を使用している一般のガザ地区住民などが含まれていた。

ある証言者は、「AIマシンがハマスの関係者と判定する場合、その人は一体ハマスにどれだけ近いのか? 実際のところは疑わしい」と、ラベンダーの不正確さを批判して言う。

「境界が曖昧なんだ。ハマスから給料をもらっているわけではないが、いろいろと手助けをしている人はどうなのか? 過去にハマスにいたが、いまは手を切っている人はどうなのか? マシンが疑わしいと判断するようなこれらの特徴は、それぞれ不正確にしかとらえられない」

同様の問題は、標的生成マシンが、殺害対象としてマークした人物の携帯電話を評価する際にも現れる。「戦争中、パレスチナ人はしょっちゅう携帯電話を変える。家族との連絡がとれなくなって電話を友達や妻に渡すこともあるし、紛失することもある。どの電話番号が誰のものかを判断するために、自動的なシステムに100%は頼れない」

証言者らによると、最低限の人による監視だけでは、このような欠陥を発見できないことは、軍も認識していたという。「『エラーなし』という方針はなかった。ミスは誤差の範囲として処理された」とラベンダーを使用した証言者は言う。

「その範囲と規模がとても大きいため、たとえマシンが正しいかどうか確証が持てなくとも、統計的には問題ない。だからやってしまえ、という運用だった」

「マシンはその能力を示した」と証言者Bは言う。「統計的なアプローチには、一定の規範や基準を設定してくれる力がある。この作戦では、常識では考えられないほどの量の爆撃がおこなわれた。私が覚えている限り、前例のない規模だ。そして私は、2日前に友人を失った兵士よりも、統計的なメカニズムのほうがはるかに信用できると思う。私を含め、イスラエル軍のみんなが10月7日に同胞を失った。マシンはそれに冷静に対処した。それで私たちは楽になったのだ」