「Hot Chips」カンファレンス、議論の中心はAI処理向けプロセッサー

人工知能(AI)の処理に特化したチップの製造に関連した科学と工学の分野は、かつてないほど活気に満ちている。Hot Chipsカンファレンスでは、最新のプロセッサーについての議論や新製品の発表が行われ、数多くの参加者が集まった。

ニューラルネットワークを活用したAIを動かす専用チップに注目が集まる中、OpenAIのTrevor Cai氏はChatGPTについて基調講演を行い、計算量のスケーリング則について説明した。

OpenAIは今後も困難なアルゴリズムのイノベーションに取り組み、大規模なクラスターを構築するための投資や逆風と戦っていくことが必要とされている。

人工知能(AI)の処理に特化したチップの製造に関連した科学と工学の分野は、かつてないほど活気に満ちている。その証拠に、スタンフォード大学で米国時間8月25~27日に開催された高性能プロセッサーに関する国際カンファレンス「Hot Chips」は、参加者であふれかえっていた。

36回目となる2024年のHot Chipsには、1500人の参加者が集まった。その半数以上はオンラインライブを通じた参加者で、残りはスタンフォード大学のMemorial Auditoriumに足を運んだ人たちだ。このカンファレンスは数十年にわたり、Intel、Advanced Micro Devices(AMD)、IBMなど、さまざまなベンダーが開発した最新プロセッサーについて議論する場となっている。また、企業がこのカンファレンスを利用して新製品を発表することも多い。

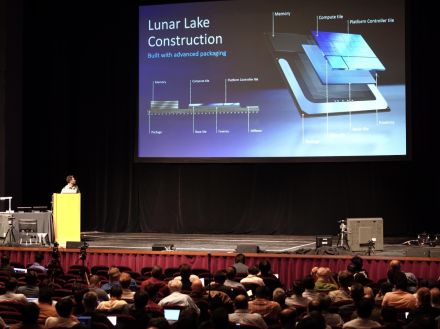

26日午前のセッションでは、Qualcomm Technologiesのデータセンター向けプロセッサー「Qualcomm Oryon」やIntelの「Lunar Lake」(開発コード名)プロセッサーのプレゼンテーションが行われ、満員の聴衆から数多くの質問が寄せられていた。

近年、大きな注目が集まっているのは、ニューラルネットワークを活用したAIをうまく動かすための専用チップだ。2024年のカンファレンスでは、OpenAIのハードウェア責任者Trevor Cai氏が基調講演で「予測可能なスケーリングとインフラストラクチャー」について語った。

OpenAIでコンピューティングインフラストラクチャーの構築に長く取り組んできたCai氏によれば、「ChatGPT」は同社が「次の単語をよりうまく予測するために長い年月と膨大な費用を費やしてきた」成果だという。そのおかげで、「ゼロショット学習」のような機能が次々と実現した。

「これがうまくいくことがなぜ分かったのだろうか」と、Cai氏は聴衆の注目を引きつけるように問いかけた。それは、使用される計算量の「べき乗則」に従って能力が予測通りに向上することを示す「スケーリング則」が存在するからだ。計算能力が倍増するごとに、精度が「それ以上減少できない」エントロピー状態に近づくと、同氏は説明した。

「このことが、大規模なクラスターを構築するための投資を可能にしている」と、Cai氏は言う。その上で、スケールカーブに沿って進み続けるには「とてつもない逆風」があるため、OpenAIは今後も極めて困難なアルゴリズムのイノベーションに取り組まなければならないと語った。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。