エヌビディア一強が崩れる可能性も 米中共同で開発が進む「大規模言語モデル」の革命的な進化

米国財務省が国家安全保障を脅かす可能性があるとして、半導体、量子コンピュータ、AIなどのハイテク分野に関する中国企業への米国企業の投資を規制する方針を示した。

大規模言語モデルの研究が進展し、1.58ビットの技術を用いた画期的な手法が米中共同開発の形で発表されている。

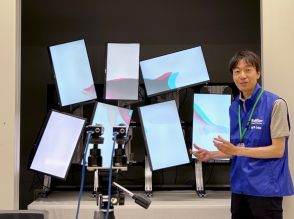

さらに、FPGAを使った専用のチップ開発により、1.58ビットの有用性を最大限に引き出す可能性が示されている。

米国財務省は6月21日、国家安全保障を脅かす可能性があるとして、半導体、量子コンピュータ、AIなどのハイテク分野に関して、米国企業による中国企業への投資を禁止、あるいは報告義務を課す規制案を公表した。8月4日までに意見公募を済ませ、年内にも実施される見通しだ。この政策は果たして米国に利益をもたらすだろうか。

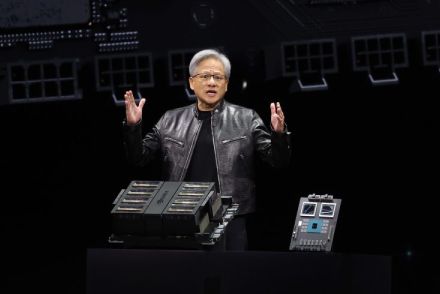

この1年の間、大規模言語モデルに関して画期的な進歩をもたらす可能性のある研究論文が発表されており、それらが一部の有識者の間で話題となっている。エヌビディア一強時代を崩すきっかけになるかもしれないという点で注目度の高い論文だが、それらは米中共同開発の形で進められている。

マイクロソフト、中国科学院大学、清華大学の研究者は2023年10月、ニューラルネットで用いられるパラメーターについて、現在使われている16進法による高精度浮動小数点(4ビット)を量子化された3つの数字(-1、0、1)(1.58ビット)に置き換えることで、行列乗算を使わず負担の小さい足し算で済ませる方法を提示した論文〈BitNet: Scaling 1-bit Transformers for Large Language Models〉を発表した。2024年3月には、その続編となる論文〈The Era of 1-bit LLMs : All Language Models are in 1.58Bits〉も発表されている。

こうした研究とは別に、UCSC、蘇州大学、UC Davisなどの研究者は6月4日、1.58ビットを用いて、大規模言語モデルから負担の大きな行列乗算を排除する方法を示す論文〈Scalable MatMul-free Language Modeling〉を発表している。

彼らはGPUの代わりにFPGA(Field Programmable Gate Array:現場でプログラムが可能な論理回路)を使って1.58ビットの有用性を示しているが、専用のチップを開発すれば、さらに高い効率が得られるだろう。