NEC、生成AIのハルシネーション対策機能を発表

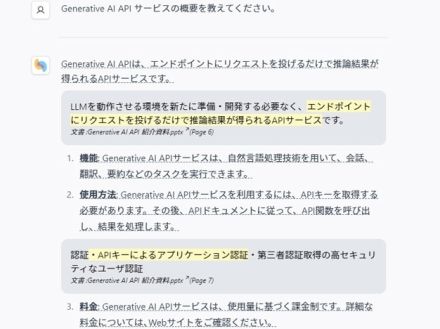

NECは10月末から、生成AIによる回答内容に誤った情報(ハルシネーション)が含まれているか確認できる機能を提供することを発表した。

この機能は、テキスト分析技術と大規模言語モデル(LLM)を活用して開発されており、元文章と生成文章を比較して食い違いがある場合にユーザーに示すことで判断が容易になる。

さらに、この機能は要約作業にも活用でき、要約前後の文章を比較してハルシネーションの有無を判定し、人的な確認作業の負担軽減や要約精度向上が期待されている。

NECは9月18日、生成AIが作成した回答内容に誤った情報(ハルシネーション)が含まれているかどうかを確認できる機能を10月末から提供すると発表した。

この機能は、同社のテキスト分析技術と大規模言語モデル(LLM)に関するノウハウを元に開発したという。LLMが文章を生成する際に元となった文章と生成した文章を比較して、食い違いがあった場合に、情報の抜け漏れや重複、元の文章と意味が変わった部分をユーザーに示し、ユーザーは単語だけでなく文章の意味を比較して判断できるという。

また、LLMによる文章の要約にも用いることで、要約前後の文章を比較してハルシネーション有無の判定が容易になり、人的な確認作業の負担軽減、要約精度のさらなる向上も期待できるとしている。検索拡張生成(RAG)などの用途でも、LLMに質問して得られた文章に対し、同機能でその根拠となる元の文章を提示することも可能で、LLMが生成した文章の正確性を効率的に確認できる。

対応するLLMは、同社開発の「cotomi」と「Microsoft Azure OpenAI Service」となっている。今後は、人物名や地名などの固有表現の一致度合いをスコア化する機能や文章に含まれる一貫性を検証する機能なども追加する予定だという。