LLMのセキュリティ対策は「まだ道半ば」--Splunkの首席調査官が指摘

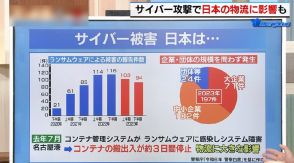

AIの活用が進む中、大規模言語モデル(LLM)とそのユーザーを保護するセキュリティ対策が重要。

LLMの脆弱性と脅威について説明。SURGeチームがOWASP Top 10を活用し、対策を提案。

プロンプトインジェクションやモデルの盗難など、具体的なセキュリティ脅威とその対策について解説。

世界的に生成AIの活用が進む中、大規模言語モデル(LLM)とそのユーザーを保護するためのセキュリティ対策は「まだ道半ばの状態にある」――。こう語るのは、Splunkのグローバルセキュリティ調査チーム「SURGe(サージ)」で首席セキュリティストラテジストを務めるShannon Davis氏だ。

SURGeチームは、サイバーセキュリティの分野で活躍する専門家たちで構成されており、新たに発生したセキュリティインシデントへの素早い対応や、セキュリティ上の問題への解決策を提供することを使命としている。特に影響範囲が広く、社会的な注目を集めるサイバーセキュリティインシデントにおいては、初動対応の技術や背景情報を提供し、最新のセキュリティトレンドを分析して研究を進め、その成果をブログやホワイトペーパー、ポッドキャストを通じて広く共有している。

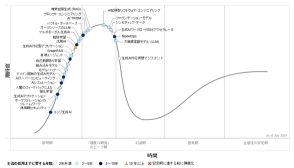

「LLMは複雑なシステムであり、従来のテクノロジーと同様に管理・保護が必要になる。この1年間、LLMベースのアプリケーションが悪用されたケースを目にしてきた」とDavis氏は語り、昨今のAI技術の急激な発展とLLMシステムの複雑性により、「セキュリティ面が十分に考慮されずに開発・導入されているLLMベースのアプリケーションが多く存在している」と指摘した。

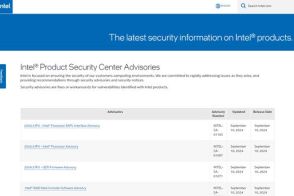

SURGeチームでは、LLMアプリケーションに対する脅威を定義するフレームワークとして、ウェブアプリケーションのセキュリティ向上を目的とした非営利団体、Open Web Application Security Project(OWASP)が提示した「OWASP Top 10 for Large Language Model Applications」を活用した。Davis氏は「LLMに関連する特定の脆弱性と脅威ベクターを理解することで、効果的な防御を実装できるようになる」と重要性を語る。

Davis氏は、その上位10項目から「プロンプトインジェクション」「安全でない出力処理」「モデルへのサービス拒否(DoS)攻撃」「機密情報の開示」「モデルの盗難」の5つについて特徴と対策を説明した。

「プロンプトインジェクション」は、意図した出力を変更するように設計された悪意のある入力を送り込むことでLLMを操作する。攻撃者がこれらの入力を作成する方法が多数あるため複雑さが生じ、単純な検出ルールを作成することは困難であるという。

しかし、Splunkの機械学習と異常検出技術を活用することで、プロンプトインジェクション攻撃を示す異常なパターンを識別するモデルを構築できる、とDavis氏は話す。また、Protect AIなど、AIシステムのセキュリティと信頼性を確保するためのソリューションも有用だという。

「安全でない出力処理」については、LLMを利用するユーザーおよびアプリケーションの両方に影響を及ぼす恐れがある。例えば、LLMのレスポンスに安全な処理が施されていない場合、クロスサイトスクリプティング(XSS)によってユーザーの環境で不正な操作が行われてしまう可能性がある。また、ユーザープロンプトも実行前に安全性をチェックする仕組みが実装されていなければ、SQLインジェクションなどによってバックエンドシステムが攻撃される恐れがある。

LLMベースのアプリケーションには、基本的なウェブアプリケーションセキュリティを実装する必要がある、とDavis氏は指摘する。また、不正な侵入が見つかった場合にそれを検出できるようにしておく必要があるという。

「モデルへのDoS攻撃」は、LLMモデルに対して非常に多くの計算リソースを消費させることで、サービス品質などを低下させる攻撃になる。

これについて、Davis氏は「幾つかの標準的なテクニックで検出できる脅威である」と説明する。プロンプトとレスポンスのセッションごとのトークン使用量、トークンを消費したユーザー、トランザクションに関わる待ち時間をログに記録することで、システムを騙してリソースを大量に消費させようとする異常値を検出するのに役立てられるという。

「機密情報の開示」は、LLMのレスポンスの中で機密情報などを開示してしまうことを悪用した攻撃になる。SURGeチームでは、Microsoftが作成した「Presidio」というツールを利用し、個人を特定できる情報(PII)を検出して匿名化した。

「モデルの盗難」についてはまだ調査中であるとしつつも、この脅威についても基本的にはプロンプトとレスポンスの分析によって脆弱性を検出できるとしている。「現在の難点は、研究に十分な規模のデータセットを見つけることだ」(Davis氏)

「生成AIの領域は、これまでにないほど急速に変化しているため、新たな脅威に遭遇することは間違いなく、それに対抗するための新たな防御策も登場するだろう。生成AIの特徴を十分に理解しないと、脆弱性を作ってしまう可能性がある。LLMベースのアプリケーションをより適切に保護するために(SURGeチームの情報を)役立ててほしい」(同氏)