アップルが直面する「AI時代のデータ保護」という難題

AppleがAI技術に取り組む中で、データセキュリティとプライバシーへの取り組み方が注目されている。

Appleは他社と異なり、プライバシーやセキュリティ確保を優先し、ChatGPTなどの技術を導入する一方、ユーザーの情報を最小限に留める方針を明確にしている。

特に、AIモデルとの提携に際しては、ユーザーの許可を得て情報共有を行なうとしているが、セキュリティの課題や情報漏洩のリスクも議論されている。

今や、テクノロジー業界のほぼすべての企業が人工知能(AI)ブームに乗っている。Appleも例外ではない。Appleが他社と少し違うのは、AIがもたらすデータセキュリティとプライバシーの問題への取り組み方だ。

Appleは6月、年次開発者会議「WWDC」で独自のAI「Apple Intelligence」を発表し、AIにおけるプライバシーとセキュリティに新たな基準を打ち立てると約束した。その一方で、Appleは自社の製品やソフトウェアをOpenAIが開発する「ChatGPT」と「シームレスに統合」する計画も進めている。

Appleの意図を疑うわけではない。しかし一部のセキュリティ専門家は、Appleが業界では珍しく公共の利益に配慮していることを認めつつも、Appleが取り組まなければならない課題は多く、サイバー犯罪の新たな標的となる可能性もあると指摘する。

AIを取り入れるにあたり、Appleがセキュリティやプライバシー、透明性の確保を約束していることは「正しい方向への一歩だ」とWing Securityの最高執行責任者(COO)、Ran Senderovitz氏は指摘する。Wing Securityは企業システムに使われているサードパーティー製ソフトウェアのセキュリティ確保を支援する企業だ。

こうした約束は、最小限のデータのみを収集し、かつ営利目的で使用しないというAppleの長年の方針とも一致しているとSenderovitz氏は言う。そして、これこそが明確な規制がいまだに存在せず、独自の規範や基準さえない無法地帯のような業界で、Appleを際立たせているものでもある。

Appleと対照的に、MetaやGoogleはAIが普及するはるか前から、ユーザーのデータを収集・共有し、業者や広告主に販売するビジネスモデルを構築してきた。

しかし大規模言語モデル(LLM)や機械学習などのAIツールは、飛躍的な進歩や革新を可能にする一方で、プライバシーや情報の機密性の面では重大な問題を引き起こす恐れがあるとSenderovitz氏は言う。

ChatGPTのようなツールにデータを提供することは、「友人に秘密を打ち明けながら、その秘密を忘れてほしいと願うようなものだ。しかし、一度聞いた秘密を友人が忘れることはない」と同氏は言う。LLMにデータを提供してしまえば、データの行き先を知ることもコントロールすることも難しくなる。入力したデータが即座に破棄されたとしても、LLMがそのデータから学んだことは消えない。

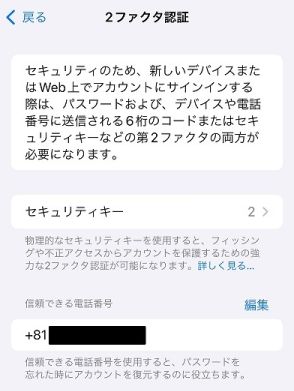

Apple Intelligenceでは、広く使われているChatGPTが大きな役割を果たすことになる。2024年内には、Siriや文章作成ツールでApple Intelligenceを利用できるようになる予定だ。Appleは、ChatGPTを使用するかしないかはユーザーが決定でき、情報を共有する際は必ずユーザーの許可を求めることを約束している。

Appleはこれまで、ソフトウェアやデバイスの動作に必要な最小限のデータだけを収集することで、消費者データのセキュリティとプライバシーを守ってきた。また、機密データをクラウドサーバーに送ることなく、デバイス上で処理できるだけの演算能力を備えたスマートフォンやコンピューターを開発してきた。

そもそもデータを収集しなければ、データの紛失や盗難、販売も生じない。しかしAIの性質上、この状況は変わるだろう。LLMをトレーニングし、その性能を高めるためにはデータが必要だ。また、一部のAI処理は一般的なスマートフォンやノートPCでは実行できない。

WWDCの基調講演でAppleのソフトウェアエンジニアリング担当シニアバイスプレジデントのCraig Federighi氏は、本当に役立つAIを実現するためには、ユーザーの普段の行動や人間関係といったパーソナルコンテキストを理解することが不可欠だが、それは正しい方法で行われなければならないと語った。

「自分の生活に関する詳細がすべて公開され、誰かのAIクラウドに保存されたり、分析されたりするようなことが起きてはならない」とFederighi氏は言う。

こうした事態を避けるために、Appleは今後もAI処理を可能な限りデバイス上で行うと約束する。スマートフォンやコンピューターでは演算能力が足りない場合に限り、より高い処理能力を持ち、より大規模なAIモデルを利用できる「Private Cloud Compute」システムにデータが送られる。

Federighi氏は、送られたデータをAppleが保存したり、アクセスしたりすることはないと請け合った。また、他のApple製デバイスと同様に、独立した専門家がサーバー上で実行されたコードを検証し、Appleがこの約束を果たしているかを確認できると述べた。

Private Cloud Computeのプライバシー

Trend Microのセキュリティ研究者で、AIシステムの分野で20年を超える経験を持つJosiah Hagen氏は、Appleが約束を果たすために最善を尽くすことを疑ってはいない。また、Private Cloud Computeにはセキュリティ面の利点があることも認める。規模が大きいため異常を発見しやすく、トラブルの芽を早い段階で摘めるからだ。

重要なのは、サイバー犯罪者がAIを悪用して、AIを利用しているアプリに想定外の動作をさせることを防ぐ仕組みを組み込めるかどうかだとHagen氏は言う。

同氏は「今後はAIモデルが乗っ取られ、不正な目的に利用されるケースが出てくる」と予測した上で、サイバー犯罪者はChatGPTを使って盗んだデータの山を掘り起こすこともできるが、無料のAIボットを大量に使った方が、この作業を速く、安価に実行できるとした。

Hagen氏は、Appleが自社クラウドのセキュリティ確保に外部企業を活用していない点も懸念している。自社で構築したセキュリティ体制の穴を自社で見つけることは難しい。サイバー攻撃者よりも先に穴を見つけるためには、外部の視点を取り入れる必要がある。

「Appleはセキュリティ会社ではない」とHagen氏は言う。「自社のエコシステムのセキュリティを自社で確保することは困難だ。どんな企業にも盲点はある」

しかも、これまではPCや「Windows」システムを研究してきたサイバー犯罪者たちが、最近はマルウェアを使って「iOS」システムを攻撃するケースが増えている。Appleのクローズドなシステムがこうした攻撃を防げる保証はない。Hagen氏が懸念しているのは、ChatGPTとの提携よりも、むしろAppleのクローズドシステムモデルだ。

Appleが防衛力を高めるためには、システムのバグを見つけて企業に報告し、報奨金を受け取るフリーのセキュリティ専門家たちが、これまで以上に重要な役割を果たすことになるとHagen氏はみている。

プライバシーに関しては、法律上あるいはコスト上の問題から、Appleがプライバシー慣行を見直し、消費者のデータを次世代AIのトレーニングに活用できるように利用規約を変更する可能性があるとHagen氏は言う。

Senderovitz氏もこの点を懸念している。同氏のチームはAppleの規約、特にOpenAIのようなサードパーティーとのデータ共有に関する規約の変更に目を光らせている。Appleはユーザーのプライバシーを守ると豪語しているが、その詳細はほとんど分かっていない。

「小さな文字で書かれた細則を注視していく必要がある」と同氏は述べた。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。