GPT-4超え性能を実現した国内スタートアップELYZA、投資額の多寡ではなくチャレンジする姿勢こそ大事

ELYZA(イライザ)が、700億パラメータの「Llama-3-ELYZA-JP-70B」と、80億パラメータの「Llama-3-ELYZA-JP-8B」を開発した。これらは日本語に特化した国産LLM「ELYZA LLM for JP」の最新モデルである。

ELYZAは東京大学 松尾研からスピンアウトしたAIスタートアップであり、LLMの研究開発と社会実装を行っている。社会実装ではJR西日本、明治安田生命、東京海上日動と協業をしている。

ELYZAが日本語LLMの性能向上に貢献し、特化型LLMの開発を進めている。特化LLMは日本の知識や業界に特化したモデルの開発を目指している。

ELYZA(イライザ)が、700億パラメータの「Llama-3-ELYZA-JP-70B」と、80億パラメータの「Llama-3-ELYZA-JP-8B」を開発した。日本語に特化した同社の国産LLM(大規模言語モデル)である「ELYZA LLM for JP」の最新モデルと位置づけている。

今回のひとこと

「相手が1兆円規模の開発投資を行う企業であっても、追いつかないと思ったら、その時点で試合は終了である。あきらめなかったことで、GPT-4などのグローバルプレイヤーに追いついた。だが、どうやって勝てるかは、もう少し考えなくてはならない」

ELYZA(イライザ)が、700億パラメータの「Llama-3-ELYZA-JP-70B」と、80億パラメータの「Llama-3-ELYZA-JP-8B」を開発した。日本語に特化した同社の国産LLM(大規模言語モデル)である「ELYZA LLM for JP」の最新モデルと位置づけている。いずれも、MetaのLlama3をベースに、日本語による追加事前学習および指示学習を行い、数1000万円の開発投資を行って完成させたという。

ELYZAの曽根岡侑也CEOは、「高性能モデルでは、GPT-4と比べても、全体的に同等の水準であり、推論能力ではELYZAのほうが優れている。国産モデルがどこまで進化していのかを体験してもらえる」と自信をみせた。

東京大学 松尾研からスピンアウトしたAIスタートアップ

ELYZAは、2018年9月に、東京大学の松尾豊教授による松尾研究室からスピンアウトして設立したAIスタートアップ企業であり、2019年夏から、LLMの研究開発と、LLMの社会実装を軸に事業を展開している。

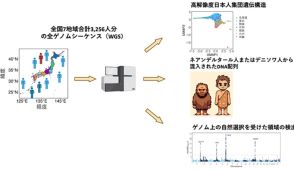

研究開発では、2020年秋に、人間の能力を超える日本語LLMの開発に成功。2021年夏には要約AIをリリース。2022年春には執筆AIをリリースした。さらに、2023年8月には70億パラメータのモデルを公開し、2023年12月には130億パラメータのモデルを公開。さらに、2024年3月には、Llama 2をベースにした700億パラメータの「ELYZA-japanese-Llama-2-70b」を発表し、GPT-3.5 Turboなどのグローバルモデルに匹敵する性能を達成した。これは、経済産業省の大規模言語モデル構築支援プログラムを活用。産総研のスパコン「ABCI」を独占的に割り当ててもらうことで開発することができたという。

「NECやNTT、ソフトバンクがフルスクラッチでLLMを開発しているのとは異なり、ELYZAでは、グローバルなオープンモデルをベースに、独自のデータセットを活用して、日本語を追加で事前学習させ、日本語に特化したポストトレーニングを実施する。0歳児から育て上げて、優秀な20歳の日本人を作り上げるのではなく、米国からスタンフォード大学の学生を連れてきて、日本語を教え込み、日本語を話せて、賢い学生を作り上げるというようなことをしている。これにより、日本語に強いモデルを開発することができる」と、ユニークな例えで説明した。

また、社会実装については、JR西日本、明治安田生命、東京海上日動などと協業。さらに、「自分たちで開発したLLMにこだわらず、OpenAIやGoogle、Anthropicなどが開発したLLMも活用し、社会にどう活用したら価値が出るのかといったことに取り組んでいる」とする。

創業者の曽根岡侑也CEOは、1990年東京都生まれ。東京大学大学院工学系研究科松尾研究室修士卒。深層学習を用いた需要予測や系列予測、自然言語処理などを研究分野とし、学生時代に未踏プロジェクトに採択され、クロードテックを創業。その後、松尾研究室において共同研究のプロジェクトマネジャーや、NLP講座の企画および講師を務め、2018年にELYZAを設立。2020年からは、松尾研究所 取締役を兼任している。

また、ELYZAは、2024年4月に、KDDIが43.4%、KDDI Digital Divergenceが10.0%の株式を取得し、KDDIの連結子会社となった。これにより、KDDIグループが持つ計算基盤や、ネットワーク資源などのアセットを活用した研究開発を推進しており、曽根岡CEOも、「この分野は、研究力があれば勝てるというものではない。今回の国産LLMの開発においても、KDDIグループに入ったことで、稼いだお金を計算機の投資にあてるという仕組みから、計算機リソースを優先的に確保でき、大胆な開発投資ができるようになり、大きな効果があった。今後、LLMを拡販していく上でもメリットが大きい」と語る。

AIスタートアップ企業にとって、大きな壁となる計算機リソースを確保できるという点では大きな追い風を得たことになり、LLMの開発を一気の加速できる体制が整ったといえるだろう。

また、KDDIでは、コンタクトセンターでのAI活用を推進しており、コンタクトセンター特化型LLMなど、領域特化型LLMの開発を加速するといった点でもシナジー効果が生まれそうだ。

ELYZAでは、オープンモデル活用型の日本語汎用LLMの開発だけでなく、生成AIを活用したDX支援やAI SaaSの提供などに取り組んでいくという。

Llama-3-ELYZA-JP-70BとLlama-3-ELYZA-JP-8B

今回開発した国産日本語LLMは、高性能モデルである700億パラメータの「Llama-3-ELYZA-JP-70B」と、PCでも利用できる軽量モデルとして80億パラメータの「Llama-3-ELYZA-JP-8B」の2つを用意している。

70BモデルはGPT-4やClaude 3 Sonnetなどの商用グローバルモデルを上回る性能を実現。チャット形式のデモを提供し、多くの人が利用できるようにする。今後は、高性能な国産モデルと位置づけ、企業向けに提供することを予定している。

ベンチーマークの結果は、ELYZA Tasks 100では4.070、Japanese MT-Benchでは平均で9.075のスコアを達成したという。2024年3月に発表したELYZA-japanese-Llama-2-70bでは、ELYZA Tasks 100のスコアが3.485、Japanese MT-Benchの平均スコアは7.500であり、大幅に性能が改善している。また、GTP-4では、ELYZA Tasks 100のスコアが4.030、Japanese MT-Benchでは平均が9.013となっており、それらの数値を上回っている。

「Japanese MT-Benchでは、8つのタスクで評価しているが、数学ではやや弱い部分がある。だが、執筆やロールプレイ、抽出、推論、人文科学の知能、科学技術の知能、コーディングでは高い性能を達成している。複雑なプロンプトに従い、抽出や要約を行い、JSONで出力することもできる」と述べた。

一方、軽量モデルとなる8B(80億パラメータ)モデルでは、ELYZA Tasks 100では3.655、Japanese MT-Benchでは平均で7.775のスコアとなっており、3月発表の700億パラメータのELYZA-japanese-Llama-2-70bの性能も上回るという大幅な進化を遂げている。また、GPT-3.5 turboでは、ELYZA Tasks 100が3.475、Japanese MT-Benchの平均スコアが8.538となっており、同等水準の実績になっている点も見逃せない。

「オープンモデルのなかでは最高水準の性能を達成しており、数100億パラメータのオープンモデルと比較しても遜色がない日本語性能を持った軽量なモデルであり、一般的なPCでも動作させることができる。一般公開を行う予定であり、LLAMA 3 COMMUNITY LICENCEに準拠し、Acceptable Use Policyに従えば、研究利用のほか、商業目的での利用も可能になる。PCやエッジデバイスでも利用してもらい、自分たちにフィット感がある形で利用してもらいたい」とした。

LLM開発は日本においても活発化している

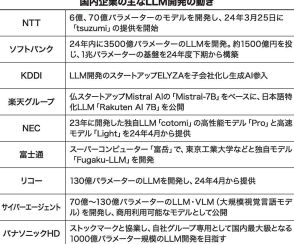

説明会でELYZAの曽根岡CEOは、日本においても、LLM開発が活発化している現状について説明した。

「米国企業を筆頭に、世界各国で様々なプレイヤーがLLM開発を進めているが、日本でも大手ITベンダーを中心に独自モデルを開発しており、NECやNTTでは、サービス提供も始まっている。さらに、研究機関や大学、AIスタートアップなども、LLM開発を推し進めており、国立情報学研究所や東京大学 松尾・岩澤研究所、sakana.ai、rinna、Preferred Elements、Turingをはじめ、研究成果としては50以上のモデルが公開されている。加えて、2023年から、日本の政府がLLM開発に対して予算をつけ、支援を推し進めており、大規模言語モデル構築支援プログラムやGENIACプロジェクトがある」と、LLMに関するこれまでの経緯に触れる一方で、「2023年末時点では、ChatGPTなどのグローバルモデルは、3歩ぐらい先を行っており、国内モデルの性能は大きく差をつけられていた。2024年3月以降は、さらに状況が変化し、OpenAIのGPT-4oや、GoogleのGemini 1.5 Pro、AnthorpicのClaude 3.5 Sonnetなど、相次いで新たなモデルが公開されたほか、クローズドモデルの商用ラインに匹敵するオープンモデルとして、Mistral AIのMixtral 8x22b、MetaのLlama 3、AlibabaのQwen2が登場し、日本語性能でも、この4カ月でトップラインが次々と更新された。だが、そうしたなかでも、今回発表した日本語LLMは、高い性能を発揮することができている」と位置づけた。

Chat GPTに対抗できるLLMの開発を

さらに、曽根岡CEOは、「ELYZAでは、2023年からは、Chat GPTに対抗することを考えて、LLMの開発を進めてきた。そして、今回は、到底たどり着けないと考えていたグローバルトップラインのGPT-4を超える性能を実現した。公開されているグローバルモデルと比較しても十分に活用できるというレベルに到達している。Llama3モデルに比べても、独自の学習をさせたことで、日本語性能を上げることに成功した。1兆円規模の開発投資を行う企業に対して、追いつかないのではないかとあきらめたり、疑心暗鬼になったりすることもあったが、あきらめずにやった結果、追いつくことができた。追いつけないと思ったらその時点で試合は終了である」と、今回の日本語LLMの開発に挑んだ姿勢について明かした。

だが、「どうやって勝てるかは、もう少し考えなくてはならない」とも語る。その上で、「例えば、汎用モデルができないことを探索することも必要である。また、領域を特化するといった道筋も、今後は重要になるだろう。たとえば、日本は製造業が多い。製造業に関してはピカイチのLLMを作るのも勝ち筋のひとつになる」と語った。ELYZAでは、汎用LLMをベースに、業界特化LLM、企業特化LLM、タスク特化LLMの開発を進めることを明らかにしている。

「特化LLMの開発においては、第1弾として、日本の知識に詳しいLLMを作る取り組みを進めている。経済産業省のGENIACプロジェクトに採択されており、法律や行政などの日本の知識や表現に対して、フィットするするLLMとなる。また、第2弾、第3弾の特化LLMも仕込んでいるところである」とした。

「選ばれるLLM開発」を掲げているELYZAは、日本語LLMの性能向上に大きく貢献するとともに、日本の企業のAI活用を、特化型という観点から促進していくことになりそうだ。

文● 大河原克行 編集●ASCII